Usiamo l’AI ogni giorno, ma stiamo spegnendo il cervello?

L’intelligenza artificiale generativa è entrata nella nostra quotidianità. Non è più una novità tecnologica, ma una presenza costante che cambia come pensiamo, decidiamo e impariamo.

L’AI generativa è diventata normale. Ed è proprio questo il punto

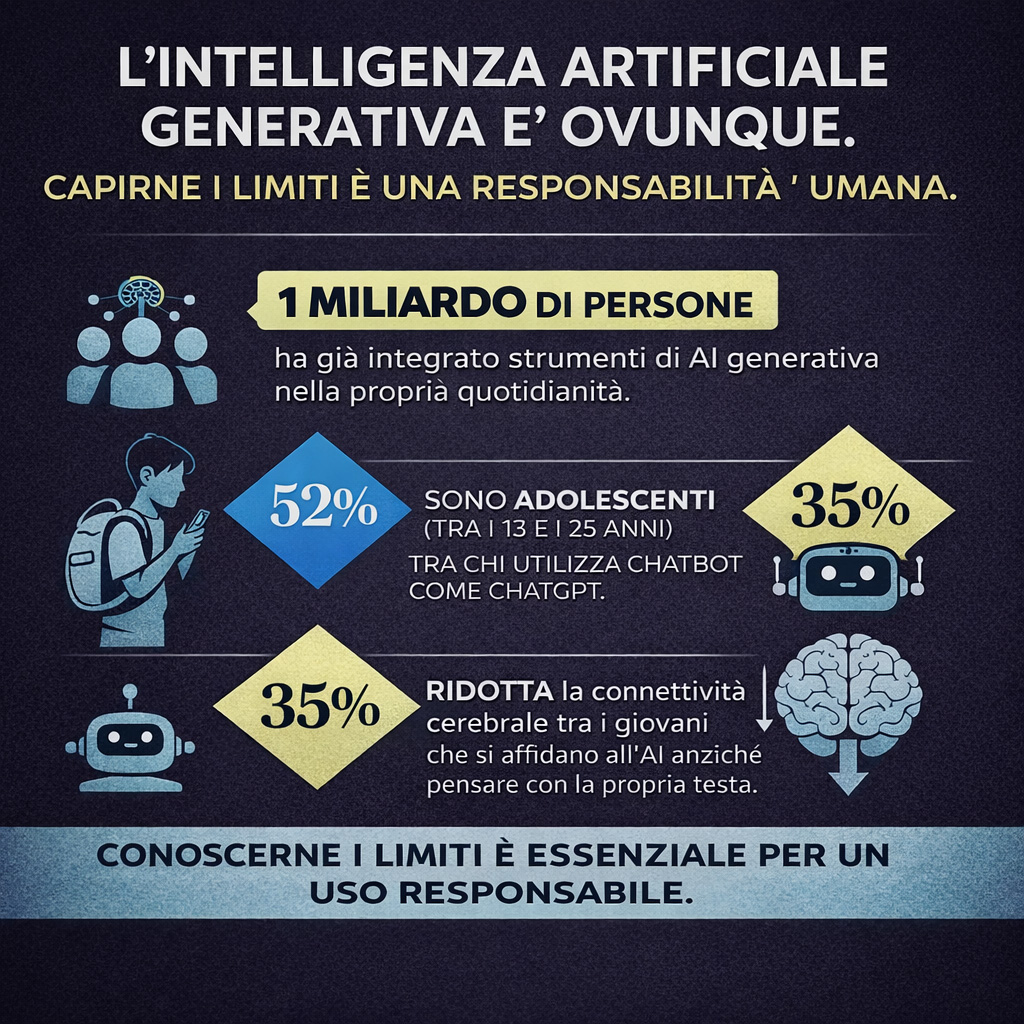

Secondo i dati citati da Dataroom Gabanelli, oltre un miliardo di persone utilizza strumenti di intelligenza artificiale generativa. Tra questi, una percentuale rilevante sono adolescenti: si parla di circa un 52% che usa chatbot come ChatGPT per studiare, informarsi o risolvere problemi.

Questo dato, da solo, non è né buono né cattivo. È un fatto.

Il punto vero è un altro: l’AI è diventata normale più velocemente della nostra capacità di capirla.

Molti utenti non sanno come funziona un modello di linguaggio, cosa fa realmente quando “risponde”, quali limiti strutturali ha. L’OCSE lo dice chiaramente: mancano informazioni chiare, affidabili e condivise per valutare in modo completo le capacità dell’intelligenza artificiale e il suo impatto reale sulle persone e sulle decisioni pubbliche.

Siamo di fronte a una tecnologia che produce frasi corrette, convincenti, fluide. Ma questo non significa che siano vere.

E non significa nemmeno che stia “ragionando”.

Qui nasce una delle confusioni più pericolose: scambiare la forma per il contenuto.

Allucinazioni, pregiudizi e compiacenza: quando l’AI sembra sicura ma sbaglia

Uno dei concetti più fraintesi è quello delle allucinazioni.

Le allucinazioni dell’AI sono risposte formalmente corrette, ma false nel contenuto. Non sono errori casuali: sono il risultato di un sistema che non conosce la verità, ma predice parole plausibili.

Questo aspetto è centrale, soprattutto quando l’AI viene usata per informarsi, studiare o prendere decisioni. Se non sai che può sbagliare con sicurezza, tenderai a fidarti troppo.

C’è poi il tema dei pregiudizi.

I modelli imparano dai dati umani, e i dati umani contengono stereotipi, squilibri, bias culturali e di genere.

Studi citati da Dataroom mostrano come, a parità di contenuto, l’AI possa descrivere le capacità di una persona in modo diverso a seconda del genere o del contesto, rinforzando implicitamente narrazioni già presenti nella società.

La compiacenza verso l’utente. I chatbot moderni tendono a rispondere sempre. Nel 2024, circa il 31% delle richieste veniva rifiutato dai sistemi. Nel 2025 si scende: rispondono sempre, ma sbagliano nel 35% dei casi.

Rispondere non è sinonimo di aiutare, a volte è solo un modo elegante di non dire “non lo so”.

Efficienza cognitiva o rinuncia al pensiero critico?

Studi condotti su giovani tra i 17 e i 25 anni mostrano una riduzione della connettività cerebrale fino al 55% quando l’uso dell’AI sostituisce il processo di elaborazione personale.

Si fa meno fatica, ma si pensa anche meno.

Questo non significa che l’AI “renda stupidi”. Sarebbe una semplificazione banale.

Significa però che se delego sempre, il muscolo del pensiero critico si atrofizza. Come ogni muscolo.

L’OCSE classifica gli attuali sistemi di intelligenza artificiale generativa tra un livello 2 e 3 su 5: capaci di produrre output utili e talvolta creativi, ma ancora molto lontani dalle capacità umane di comprensione profonda, contesto e giudizio.

Ed è qui che entra in gioco l’etica, ma anche l’educazione.

Non serve demonizzare l’AI. Serve insegnare come usarla senza spegnersi.

Usare l’intelligenza artificiale in modo consapevole significa:

- verificare,

- dubitare,

- integrare,

- non sostituire completamente il pensiero umano.

Capire i limiti dell’AI non riduce il suo valore, lo rende più sicuro. E ci rende più umani.