Quando il software non basta più e l’AI inizia a divorare tutto il resto

L’intelligenza artificiale non è solo uno strumento. Sta cambiando cosa consideriamo “software”, cosa resta “hardware” e soprattutto come attribuiamo valore alle cose che usiamo ogni giorno.

Il software ha vinto

Per più di dieci anni abbiamo vissuto dentro una verità semplice: il software ha mangiato il mondo.

Non come slogan, ma come fatto concreto. Le aziende più potenti non producevano oggetti, ma sistemi. Interfacce, piattaforme, servizi capaci di risolvere problemi reali con costi marginali sempre più bassi.

Il software non ha solo reso tutto più veloce. Ha reso invisibile la complessità.

Cose che prima richiedevano tempo, spostamenti, persone, oggi si risolvono con pochi gesti. Senza pensarci. Senza accorgerci di quanta materia, energia e organizzazione siano state eliminate dal processo.

Ora sta succedendo qualcosa di diverso.

L’intelligenza artificiale non si limita ad accelerare il software esistente. Lo sta assorbendo. Sempre più codice non viene scritto, ma suggerito. Sempre più funzioni non vengono progettate, ma scoperte dialogando con un modello.

Il software, da istruzione rigida, sta diventando comportamento. Non dici più al sistema cosa fare. Gli spieghi il contesto e il sistema decide come arrivarci.

Questo cambia profondamente il nostro rapporto con la tecnologia.

Non stiamo più usando strumenti. Stiamo collaborando con sistemi che interpretano, generalizzano, anticipano. E questo apre una domanda che va oltre la produttività: chi è responsabile delle decisioni quando il software smette di essere deterministico?

Quando l’AI non mangia solo codice ma anche materia

C’è un’idea diffusa secondo cui l’AI sarebbe “immateriale”.

In realtà è vero l’opposto. L’intelligenza artificiale funziona perché dietro c’è molto hardware, molta energia, molta infrastruttura. Data center, chip, sensori, reti fisiche.

Ma qui accade qualcosa di controintuitivo, più l’AI diventa capace, più tende a ridurre l’hardware necessario a valle. Lo vediamo bene nei sistemi complessi.

Per anni abbiamo pensato che per rendere il mondo intelligente servisse riempirlo di sensori, apparati, strati tecnologici. Strade intelligenti, oggetti iperstrumentati, ridondanza ovunque.

Ora sta emergendo un approccio diverso.

Meno hardware specializzato. Più capacità di interpretazione. Più software che “capisce” invece di misurare tutto.

In pratica, l’AI sta facendo all’hardware quello che il software aveva già fatto alle macchine tradizionali: lo sta comprimendo.

Non perché non serva, ma perché serve meglio. In modo più essenziale.

Questo passaggio è importante anche dal punto di vista etico.

Ogni volta che riduciamo materia, spostamenti, duplicazioni inutili, stiamo togliendo peso al sistema. Non per ideologia, ma per efficienza reale.

Il punto non è se l’AI consuma energia, lo fa, il punto vero è cosa evita di farci consumare. Cosa sostituisce. Cosa rende inutile.

Il vero costo energetico dell’AI non è nei server

C’è poi il tema dell’energia, spesso usato come clava nel dibattito sull’AI.

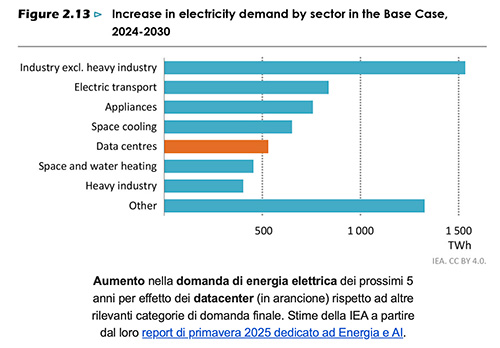

È vero: l’intelligenza artificiale consuma energia. Server, data center, calcolo intensivo. Ma la domanda onesta non è “quanto consuma”, bensì “cosa sostituisce”. Ogni volta che l’AI evita uno spostamento, una stampa, una produzione inutile, una riunione superflua o un processo inefficiente, sta spostando il consumo, non semplicemente aggiungendolo.

Il digitale non è mai stato immateriale, ma può essere straordinariamente sostitutivo. Il rischio non è usare l’AI, è usarla male: per generare rumore, duplicazioni, contenuti vuoti. Se invece viene usata per togliere peso al sistema, l’AI diventa una tecnologia di compressione energetica.

Meno attrito, meno spreco, più senso, e questo, oggi, è un tema più etico che tecnologico.

Per darvi un riferimento, 0.3 Wh per prompt è circa come:

- usare il micronde per 1 secondo

- usare un PC per 17 secondi

- usare un frigorifero (quello parte senza che nemmeno ve ne accorgiate) per 6 secondi

- Caricare lo smartphone fino al 2%

La tecnologica è umana

Quando una tecnologia abbassa drasticamente il costo marginale di qualcosa, non cambia solo il mercato, cambia la cultura.

È successo con l’informazione. Con la fotografia. Con la comunicazione. Sta succedendo ora con il pensiero operativo.

L’AI rende accessibili capacità che prima erano riservate a pochi.

Scrivere, analizzare, progettare, sintetizzare. Tutto diventa più vicino. Più immediato.

Questo è potente e anche pericoloso, se non viene compreso.

Perché quando qualcosa diventa “quasi gratuito”, rischiamo di smettere di attribuirgli valore, o peggio, di usarlo senza responsabilità.

L’AI non ci chiede solo di essere più produttivi, ci chiede di essere più consapevoli. Di decidere cosa vale la pena automatizzare e cosa no. Dove vogliamo efficienza e dove serve ancora lentezza.

Non tutto ciò che è possibile è desiderabile.

Non tutto ciò che è ottimizzabile deve esserlo.

Il mio lavoro, oggi, non è convincere le persone a usare l’intelligenza artificiale.

È aiutarle a pensare meglio mentre la usano. A costruire sistemi che non disumanizzano, ma liberano spazio. Tempo. Energia mentale.

Perché alla fine l’AI non si sta mangiando il mondo, sta mettendo alla prova il nostro modo di abitarlo.

E questa è una responsabilità che non possiamo delegare a nessun algoritmo.

Grazie a Nicolò Golinucci